Internacional - Seguridad y Justicia

El instituto donde enseñan a enfrentar a los ciberatacantes

Por ALINA TUGEND, The New York Times

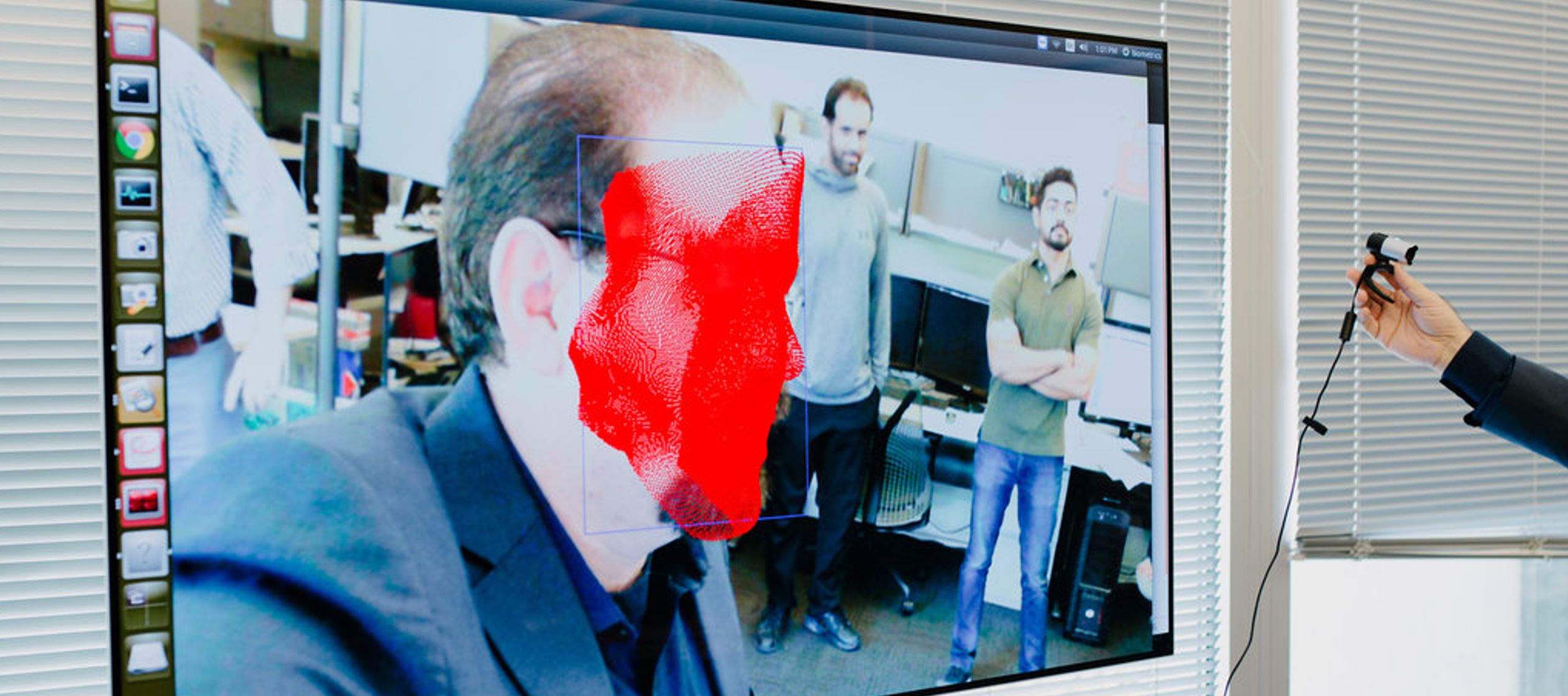

PITTSBURGH — En un laboratorio tecnológico, repleto de estudiantes de posgrado enfocados en sus computadores portátiles, el profesor Marios Savvides buscaba entre imágenes mostradas en la pantalla de su computadora en las que se veía mucha gente cuyos rostros apenas eran reconocibles para un humano.

“¿Qué tal la foto de un disturbio?”, preguntó Savvides. Acababa de toparse con una imagen de policías que llevaban puestas máscaras de gas y cascos y de manifestantes que tenían la boca y la nariz cubiertas con pañuelos mientras trataban de protegerse del aire lleno de humo y gas lacrimógeno.

Savvides estaba encantado. Era un ejemplo perfecto de cómo, con las herramientas de reconocimiento facial de inteligencia artificial, “ahora podemos reconocer un rostro a partir de muy pocos pixeles”, comentó.

Se encontraba en el Centro de Biométrica, parte del CyLab Security and Privacy Institute de la Universidad Carnegie Mellon.

El centro fue creado por Savvides, un reconocido experto en biométrica, la ciencia de medir e identificar a la gente con sistemas de reconocimiento facial y del iris. Todos los días, este espacio de alta tecnología está lleno de computadoras, robots y otras máquinas, sin mencionar a los estudiantes de doctorado que trabajan con él.

CyLab, que incluye el centro, fue fundado en 2003 para expandir los límites de la tecnología y proteger a la gente cuando esa tecnología o las personas que la usan suponen una amenaza.

CyLab trabaja en asociación con casi veinte corporaciones —como Boeing, Microsoft y Facebook— y con agencias del gobierno estadounidense para llevar a cabo investigaciones y programas educativos sobre el internet, la privacidad y la seguridad.

Este tema se ha convertido en una de las áreas más populares de investigación y capacitación en Estados Unidos, a medida que los ciberatacantes, cada vez más sofisticados, amenazan no solo la seguridad de las computadoras personales, sino también el funcionamiento de sistemas bancarios, plantas de purificación de agua y hasta arsenales nucleares. Mientras las amenazas se acumulan, el número de personas calificadas para confrontarlas se mantiene demasiado bajo, a decir de los expertos, y las instituciones académicas y agencias gubernamentales se han enfocado en la tarea de cerrar esa brecha.

Más de trescientos investigadores y estudiantes de posgrado trabajan o estudian en CyLab; es uno de los centros de capacitación en ciberseguridad más grandes del mundo. Ofrece más de cincuenta cursos de seguridad y privacidad y ha capacitado a más de 75,000 personas.

La biométrica, que usa atributos físicos difíciles de ocultar —como los rasgos faciales, las huellas digitales, los escaneos de retina y el ADN—, es solo una de las especialidades. CyLab también trabaja con usos más amplios de la inteligencia artificial, como la criptografía, la seguridad de redes y muchas otras herramientas de ciberseguridad.

Una de las primeras veces que Savvides y su grupo utilizó su tecnología de reconocimiento facial para algo más que la investigación fue justo después del bombardeo de 2015 en el Maratón de Boston. Su laboratorio usó la imagen del atacante sospechoso captada por el circuito cerrado de vigilancia y hecha pública por el FBI, que era borrosa y de baja resolución, para reconstruirla con tecnología de inteligencia artificial y enviar la versión mejorada a la agencia.

A la mañana siguiente, se reveló la identidad de Dzhokhar Tsarnaev, quien fue condenado por el bombardeo. Savvides no sabe si la reconstrucción ayudó al FBI, pero añadió: “Estuvimos muy sorprendidos de ver cuánto se parecía a Tsarnaev al rostro que pudimos reconstruir a partir de la imagen de tan baja resolución y muy pixelada que nuestro cerebro humano no podía distinguir”.

Savvides también trabaja en otros avances tecnológicos sorprendentes, como el escaneo de iris a larga distancia gracias a un dispositivo que ayudó a inventar, el cual parece un lente de cámara muy grande que tiene otro más pequeño encima y luces infrarrojas de cada lado. En vez de necesitar que un ojo se coloque directamente en un escáner, puede identificar a las personas a partir de sus iris a una distancia de hasta 12 metros.

Como las huellas digitales, los iris de cada persona son únicos: permanecen igual aunque envejezcamos y, a diferencia de las huellas dactilares, no se pueden desfigurar ni cubrir de ninguna manera que no implique remover el ojo por completo. Además, las huellas dactilares no pueden detectarse a grandes distancias.

En un video, Savvides mostró cómo sería posible que los policías identificaran al conductor de un auto que sea detenido por cometer una infracción al capturar una imagen detallada del iris de quien maneja por medio del espejo lateral. Esa imagen puede ser comparada con la base de datos policial para que los oficiales sepan, desde antes de acercarse al vehículo, si la persona está conduciendo un auto robado, si tiene antecedentes delictivos o si es parte de una lista de terroristas buscados y pudiera ser peligrosa.

Parte del trabajo de CyLab se enfoca en amenazas que afectan más a las personas en su vida diaria, entre ellas la seguridad de las contraseñas.

Lujo Bauer, director del Cyber Autonomy Research Center de la universidad, dijo que sus investigaciones mostraban que, para evitar ser víctima de un ciberataque, las contraseñas del usuario de una computadora no solo debían ser complejas, sino largas.

“Una contraseña larga que no sea tan compleja es más fuerte que una contraseña muy complicada pero corta”, dijo Bauer, profesor adjunto de informática e ingeniería eléctrica y computacional.

Explicó que tan solo cambiar algunas palabras o añadir números a una contraseña que ya se está usando no sirve mucho para detener a los ciberatacantes (hackers), que fácilmente pueden probar miles de variaciones de una contraseña con gran rapidez. Nos han dicho a todos en repetidas ocasiones que lo peor que podemos hacer es reutilizar contraseñas en distintas cuentas; así es como se han vulnerado muchas cuentas de usuarios. (Una manera de verificar si tu cuenta ha sido víctima de una filtración de información es visitar la página web haveibeenpwned.com).

Otras investigaciones de CyLab incluyen estudios sobre phishing (ciberestafas y fraude cometido por medio de correos electrónicos). Jason Hong, profesor del Instituto de Interacción entre Humanos y Computadoras de Carnegie Mellon, explicó que, pese a que se supone que ellas son más vulnerables, es menos probable que las personas de edades más avanzadas sean blanco de delitos informáticos vía correo electrónico; y es más probable que lo sean quienes tienen entre 18 y 25 años, quizá porque los jóvenes tienden a tomar más riesgos.

La mayoría de la ciberseguridad, indicó Kathleen Carley, profesora de la Facultad de Informática de Carnegie Mellon, se trata de “emplear técnicas computacionales para entender mejor a la sociedad y emplear nuestro conocimiento de esta para comprender mejor las técnicas informáticas”.

Su trabajo se basa en la ciberseguridad social, es decir, averiguar cómo hacer que las redes sociales sean “un espacio libre y abierto sin influencia indebida”. Es un tema que se ha convertido en un gran problema social a partir de la supuesta injerencia rusa en la elección presidencial de 2016 en Estados Unidos y otras campañas hechas vía plataformas como Facebook.

Carley comentó que la mayoría de la gente no se da cuenta del impacto de los bots, que ejecutan tareas automatizadas en internet. El papel de los bots es convencer a los usuarios con objetivos que pueden ser relativamente inofensivos, como dirigidos hacia cierta publicidad, pero cada vez son más usados por organizaciones o gobiernos para sembrar discordia en las redes sociales al crear o amplificar una conversación, haciéndola más virulenta y divisoria.

Los bots aprovechan la manera en que funciona el cerebro humano: la gente escucha algo que se repite una y otra vez, al parecer desde muchas fuentes, y pronto parece la verdad.

Un ejemplo, que Carley y su equipo descubrieron en 2015, fue un bot utilizado para convencer a personas de Siria y aquellos que emigraron por el conflicto para que visitaran una página web de una supuesta beneficencia para donar a los afectados. “Creemos que en realidad era un sitio de lavado de dinero para el Estado Islámico”, comentó.

En ese caso, los bots, unidos en una red llamada botnet, fueron identificados con detección humana, aunque ahora los investigadores de la inteligencia artificial han creado algoritmos para ese fin. El generado por Carley y su equipo se llama Bot-hunter (cazador de bot).

Quizá los más dañinos son los bots que generan y magnifican la discordia en las redes sociales, y “distorsionan el entorno de la información”, dijo Carley. Eso puede afectar desde cómo vota la gente hasta qué compran y qué opinión tienen de los demás en la sociedad.

Hay relativamente pocos bots en comparación con las cuentas de humanos reales, pero son tan activos que su efecto es muy desproporcionado respecto de su tamaño, comentó. Puso como ejemplo el gran papel que los bots desempeñaron en el disturbio civil de Ucrania en 2013; se cree que fueron los rusos quienes lo fomentaron.

Carley y otros están desarrollando soluciones tecnológicas, como usar la inteligencia artificial para verificar los hechos automáticamente con el fin de identificar bots y publicaciones con lenguaje nocivo. Sin embargo, Carley indicó que “las herramientas están en ciernes”, y la tecnología por sí sola no resolverá este problema. “Los creadores de políticas y la sociedad tendrán que educarse”, concluyó.

regina

Notas Relacionadas

- Estados Unidos está decidido a vigilar armas nucleares norcoreanas, con o sin la ONU

- Cómo funciona el Gabinete de Guerra de Israel

- Corea del Norte, ¿especialista en robo de critpomonedas?

- Expertos ONU investigan 58 presuntos ciberataques norcoreanos valorados en 3,000 millones

- Hackers rusos estuvieron durante meses dentro de un gigante ucraniano de telecomunicaciones